大数据技术浪潮下的数据处理 挑战、演进与未来

在当今信息爆炸的时代,数据已成为驱动社会进步和经济发展的核心资源。大数据技术,作为处理海量、多样、高速生成数据的关键手段,正深刻重塑着各行各业。而数据处理,作为大数据技术体系的核心环节,其重要性不言而喻。它不仅关乎数据价值的挖掘效率,更直接决定了决策的智能水平和业务的创新能力。

一、大数据时代数据处理的根本性挑战

传统的数据处理技术,如关系型数据库和批处理,在面对大数据时往往捉襟见肘。其挑战主要体现在四个方面:

- 体量巨大:数据规模从TB级跃升至PB、EB级,传统集中式存储与计算架构难以承载。

- 类型多样:数据来源包括结构化数据(如数据库表)、半结构化数据(如XML、JSON日志)和非结构化数据(如文本、图像、视频),处理逻辑复杂。

- 速度要求高:数据生成和流动的速度极快,要求处理系统能够进行实时或近实时的流式处理,以满足即时洞察的需求。

- 价值密度低:海量数据中蕴含高价值的信息往往稀疏,需要通过高效的处理和分析技术进行“沙里淘金”。

二、大数据处理技术的核心演进与分层架构

为应对上述挑战,大数据处理技术已发展出一套成熟的分层体系,通常可概括为:

1. 数据采集与集成层

这是数据处理的起点。技术包括日志采集(如Flume、Logstash)、数据库同步(如Sqoop、Debezium)、消息队列(如Kafka、Pulsar)以及网络爬虫等。其核心目标是高效、可靠地将来自不同源头、不同格式的数据汇聚到统一的数据平台。

2. 数据存储与管理层

这是数据的“蓄水池”。针对大数据的特性,存储技术从集中式向分布式演进。代表技术有:

- 分布式文件系统:如Hadoop HDFS,提供高容错性、高吞吐量的底层存储。

- NoSQL数据库:如键值存储(Redis)、文档数据库(MongoDB)、列式数据库(HBase)、图数据库(Neo4j),针对特定数据模型和访问模式进行优化。

- 数据湖:如基于云对象存储(AWS S3)或Delta Lake、Iceberg等表格式构建,支持存储任意格式的原始数据,为上层分析提供灵活性。

3. 数据计算与处理层

这是实现数据价值转化的“引擎”,根据时效性可分为两大范式:

- 批处理:面向历史、静态的大规模数据集,进行高吞吐量的复杂计算。以Hadoop MapReduce为开创者,随后以Apache Spark(基于内存计算,性能大幅提升)为代表,成为离线数据分析、数据仓库构建的主力。

- 流处理:面向持续生成的无界数据流,进行低延迟的实时计算。以Apache Storm为早期代表,Apache Flink(以其高吞吐、低延迟、精确一次语义和状态管理能力)和Spark Streaming成为当前主流,支撑实时监控、实时推荐、风控等场景。

Flink和Spark等框架正朝着流批一体的架构演进,旨在用同一套API和运行时处理两种计算模式,简化技术栈。

4. 数据分析与服务层

这是数据处理成果的输出端。技术包括:

- 交互式查询引擎:如Presto、Impala、ClickHouse,支持对海量数据进行亚秒级到秒级的SQL查询。

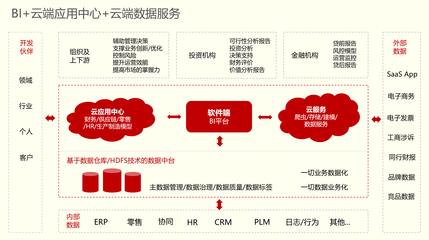

- 数据仓库与OLAP:如Hive、传统数据仓库(Teradata)及现代云数仓(Snowflake、BigQuery),为商业智能(BI)和报表提供支持。

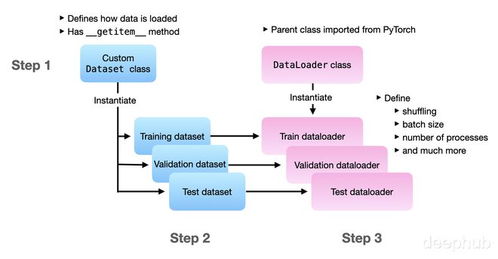

- 数据挖掘与机器学习:集成如Spark MLlib、TensorFlow、PyTorch等框架,进行预测性分析和模型训练。

- 数据可视化与API服务:将处理结果通过图表(如Tableau、Superset)或数据API的形式,提供给最终用户和应用程序。

三、数据处理流程的关键环节

在具体实践中,数据处理通常遵循一套标准流程:

- 数据清洗:纠正错误、处理缺失值、去除重复记录,确保数据质量。

- 数据转换与集成:将数据转换为统一的格式和模型,并整合来自不同源的数据。

- 数据规约与聚合:通过采样、维度归约、数值聚合等方法,在尽可能保持原貌的前提下减少数据量,提升后续处理效率。

- 数据建模与分析:应用统计方法、机器学习算法等,构建模型以发现模式、趋势和关联。

- 数据可视化与解释:将分析结果以直观易懂的形式呈现,并形成可指导行动的洞察。

四、未来趋势与展望

大数据处理技术仍在快速发展,未来趋势清晰可见:

- 云原生与Serverless化:数据处理基础设施正全面向云端迁移,基于容器(Kubernetes)和Serverless架构的服务(如AWS Glue、Azure Databricks)让用户更专注于业务逻辑,而无需管理底层集群。

- 湖仓一体与智能融合:数据湖的灵活性与数据仓库的管理性能正在融合(Lakehouse架构,如Databricks Delta Lake),数据处理与人工智能(AI)的结合愈发紧密,实现更自动化的数据治理、质量检查和智能分析。

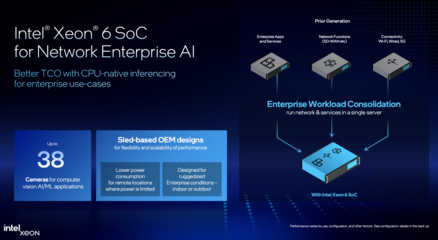

- 实时化与边缘计算:随着IoT的普及,数据处理的需求进一步向数据产生的源头(边缘端)延伸,形成“云-边-端”协同的实时处理体系。

- 数据安全和隐私计算:在数据价值挖掘的通过差分隐私、联邦学习、可信执行环境等技术,保障数据安全和用户隐私,实现“数据可用不可见”。

****

大数据技术中的数据处理,已从一项支撑性技术演变为驱动数字化转型的核心引擎。它不仅是技术的集合,更是一套将原始数据转化为智慧与决策的系统性方法论。面对持续增长的数据洪流和日益复杂的业务需求,唯有持续演进数据处理技术、优化数据处理流程,才能牢牢把握数据这一新时代的“石油”,释放其蕴藏的巨大能量,赋能千行百业的智能化未来。

如若转载,请注明出处:http://www.zzzcvip.com/product/53.html

更新时间:2026-02-25 07:46:23