数据处理 从原始素材到决策智慧的核心引擎

在信息爆炸的时代,数据已成为新时代的“石油”。如同原油需要经过复杂的提炼才能转化为可用的能源,海量、无序的原始数据也必须经过系统化的处理,才能转化为有价值的见解和决策依据。数据处理,正是这一转化过程的核心引擎,它贯穿于从收集、清洗、存储到分析、应用的全流程,是现代商业、科研与社会治理不可或缺的基石。

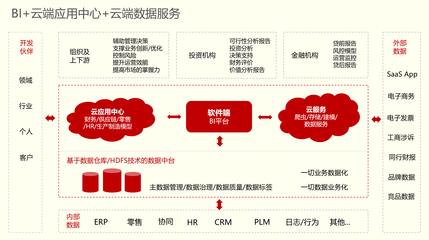

数据处理的首要步骤是数据收集与获取。数据来源广泛,既包括企业内部的事务系统(如ERP、CRM)、物联网传感器、网站日志,也涵盖来自社交媒体、公开数据库、市场报告等的外部数据。这一阶段的关键在于确保数据的全面性、相关性与合法性,为后续流程奠定坚实的基础。

紧随其后的是数据清洗与预处理,这往往是数据处理中最耗时、最关键的环节。原始数据常伴有各种“噪音”:如缺失值、错误值、不一致的格式、重复记录以及异常值等。数据清洗的目标就是识别并修正这些问题,确保数据的准确性、一致性与完整性。例如,统一日期格式、填补合理的缺失值、剔除无效记录等。只有高质量的数据“原料”,才能产出可靠的分析结果。

数据清洗后,便进入数据存储与管理阶段。根据数据量、结构(结构化、半结构化、非结构化)及访问需求,可以选择不同的存储方案。传统的关系型数据库(如MySQL、PostgreSQL)擅长处理结构化事务数据;而大数据时代下,分布式文件系统(如Hadoop HDFS)和NoSQL数据库(如MongoDB、Cassandra)更适用于海量、多样化的数据存储。数据仓库(如Amazon Redshift)和近年兴起的数据湖则为企业提供了集中化存储与分析历史数据的平台。有效的数据管理确保了数据的安全性、可访问性与可维护性。

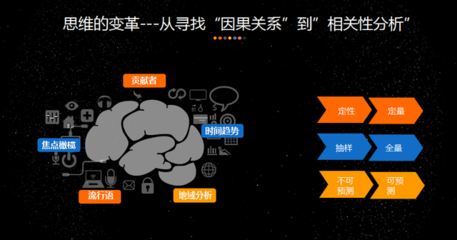

接下来是数据处理与分析的核心——数据转换与建模。这一阶段通过聚合、筛选、连接、计算衍生指标等操作,将数据转化为适合分析的形态。运用统计分析、机器学习、数据挖掘等算法,从数据中发现模式、趋势、关联与洞见。无论是描述现状的描述性分析(“发生了什么”),探究原因的诊断性分析(“为什么会发生”),预测未来的预测性分析(“可能会发生什么”),还是指导行动的规范性分析(“应该怎么做”),都依赖于此阶段的深度加工。

数据处理的最终目标是数据可视化与应用。将分析结果以图表、仪表盘、报告等直观形式呈现,能够帮助决策者快速理解复杂信息,洞悉关键问题。处理后的数据与洞见,最终被应用于各个领域:商业智能(BI)指导营销策略与运营优化,精准医疗助力个性化诊疗,智慧城市提升管理效率,金融风控防范潜在风险。数据驱动的决策模式,正日益成为组织竞争力的核心。

数据处理也面临诸多挑战。数据隐私与安全(如GDPR等法规的合规要求)、数据孤岛、处理实时流数据的需求、以及对处理速度与规模的极致追求,都在推动技术不断演进。数据湖仓一体、实时数据处理框架(如Apache Flink、Spark Streaming)、自动化机器学习(AutoML)等新技术与架构应运而生。

随着人工智能与物联网的深度融合,数据处理将更加智能化、自动化与实时化。边缘计算将处理任务推向数据产生的源头,以降低延迟并保护隐私。总而言之,数据处理已不再仅仅是IT部门的后台任务,而是赋能各行各业数字化转型、挖掘数据潜在价值、驱动创新与增长的战略性流程。掌握数据处理的能力,意味着掌握了从信息海洋中提炼真知、预见未来并塑造未来的关键钥匙。

如若转载,请注明出处:http://www.zzzcvip.com/product/52.html

更新时间:2026-02-25 09:52:58